<2019. 11. 12.>

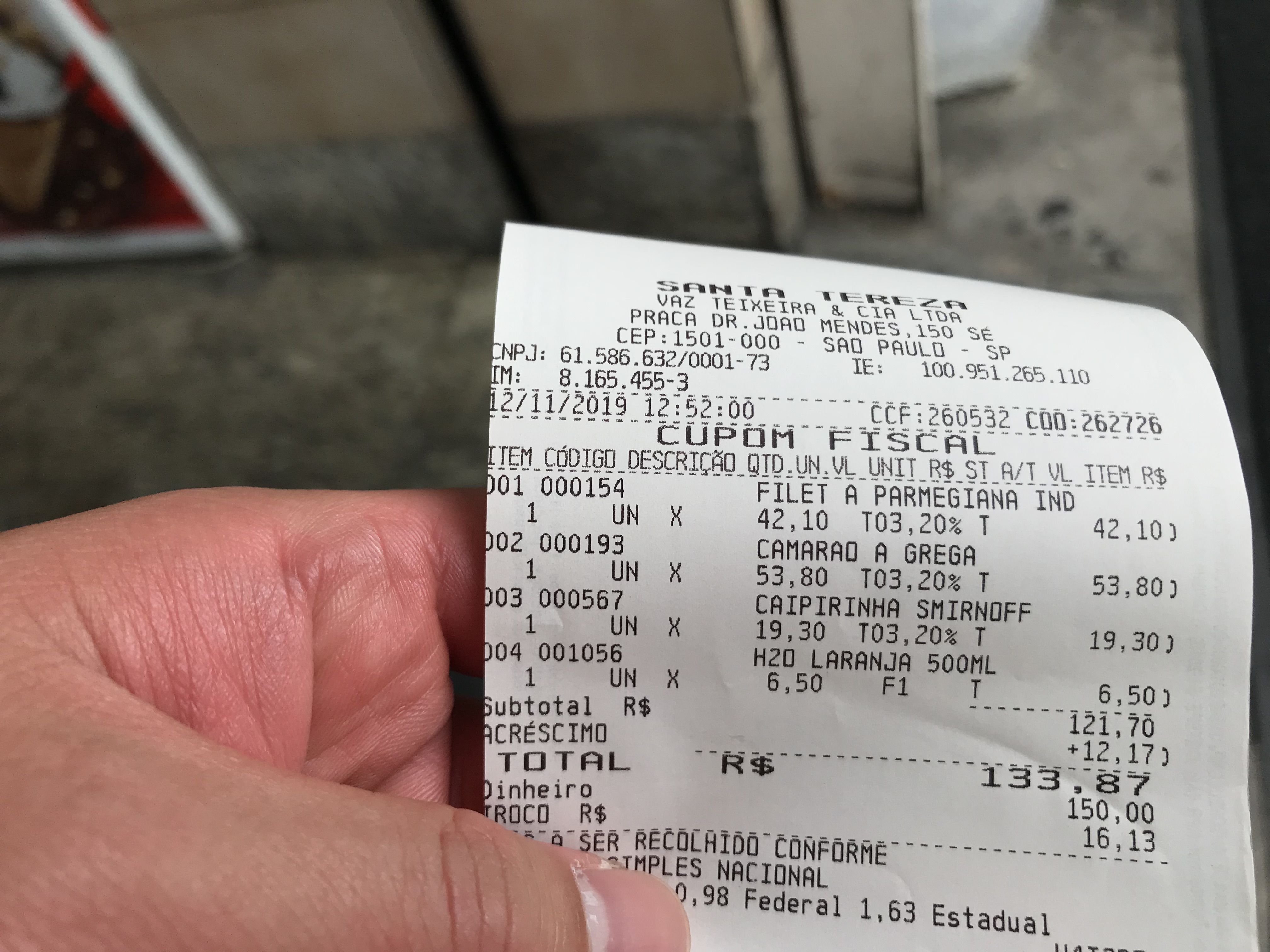

이비라푸에라공원(아침 조깅) - 리베르다지(Liberdade) - 쎄 성당 - 레스토랑(Panificadora Santa Tereza) - 복권 - 중앙시장 - 크라콜란지아(마약소굴) - 봉헤찌로(한인타운) - 이탈리아 빌딩(전망대) - 아우구스타 거리 - 트리아농 공원 - 상파울루 미술관(MASP) - 맥도날드

점심식사를 마치고 주차장으로 가는 길,

사람들이 몰려있는 복권가게를 보고 그냥 지나칠 수 없었다.

브라질에서는 ‘복권’에 대한 열기가 뜨겁고, 보편적이라고 한다.

세계에서 소득 불평등 정도가 심한 국가 중 하나이다 보니,

많은 사람들이 복권을 통해 부자가 되는 것이 더 쉽다고 믿고 있다고 한다..

비단 소득 불평등 정도 때문일까.. 싶기는 하다.

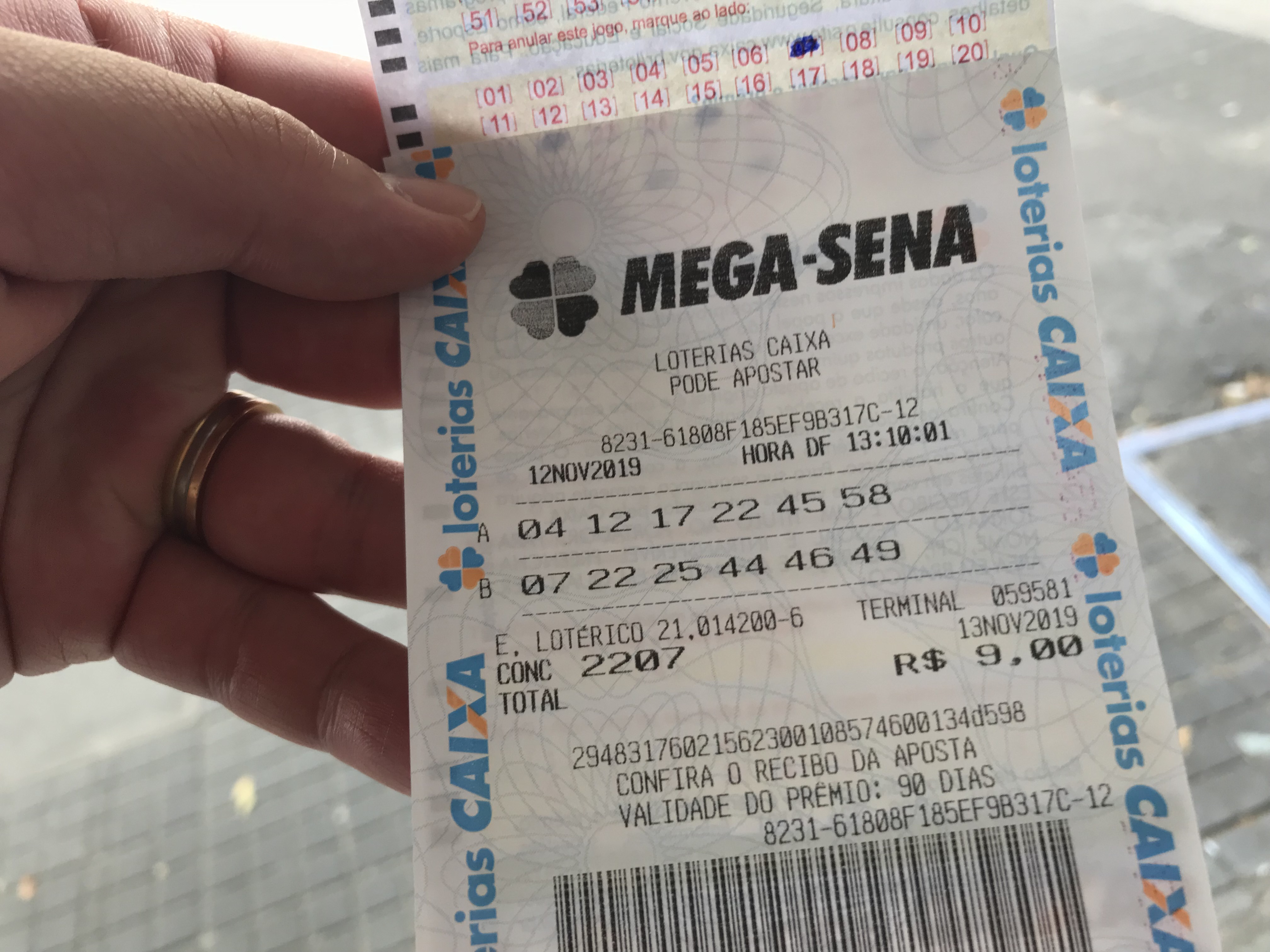

브라질에서 상금이 가장 많은 복권종류인 MEGA-SENA 도전!

2019. 11. 10.부터 복권 가격도 전체적으로 인상된듯..

브라질 복권 MEGA-SENA는 우리나라 로또와 유사한 방식으로,

50개의 숫자 가운데 6개를 선택하는데,

다른 점은 돈을 추가하면 숫자를 더 추가선택하여 당첨확률을 높일 수 있다는 점이다.

그러나 추가되는 금액이 어마무시하여, 대개 6개만 선택한다고..

※ 참고 :

브라질에서 합법적으로 체류하고 있는 신분 상태라면, 외국인도 브라질 복권 구매/당첨금 지급 가능하다고 한다.

당첨금 지급 시, CPF 금융번호가 반드시 있어야 하는데,

브라질 비거주자용 CPF 번호 발급 제도를 이용하면 된다고 ^^

'해외여행(Travel) > Sao Paulo' 카테고리의 다른 글

| [브라질 상파울루 4일차] 마약의 땅, 마약소굴, 마약 거리(cracolândia) (0) | 2019.12.30 |

|---|---|

| [브라질 상파울루 4일차] 상파울루 중앙시장 (Municipal Market of São Paulo) (0) | 2019.12.30 |

| [브라질 상파울루 4일차] Panificadora Santa Tereza (음식점) (0) | 2019.12.30 |

| [브라질 상파울루 4일차] 쎄 성당(Categral da Sé) (0) | 2019.12.30 |

| [브라질 상파울루 4일차] 리베르다지(Liberdade) (0) | 2019.12.30 |